Sie ist momentan in aller Munde. Die einen fürchten sie, die anderen lieben sie: Künstliche Intelligenz (KI). Ein großes Thema mit viel Hintergrund. Ich möchte etwas Licht ins Dunkel bringen und dir hier einen Überblick geben, was künstliche Intelligenz bedeutet und welche Auswirkungen sie auf die digitale Barrierefreiheit haben kann. Und natürlich gibt es ein paar praktische Tipps mit auf den Weg, also los geht’s!

Was ist künstliche Intelligenz überhaupt?

Als künstliche Intelligenz bezeichnen wir die Fähigkeit von Technologie logisch zu denken, zu lernen, Probleme zu lösen und Muster zu erkennen. Ein wenig so, als würden wir einer Maschine beibringen, wie ein Mensch zu denken. Klingt erst mal verrückt, beruht aber auf technischen Grundlagen.

Machine Learning

Zum Beispiel lernen Maschinen Entscheidungen oder Vorhersagen zu treffen. Sie müssen dafür nicht für jede neue Aufgabe explizit programmiert werden. Stattdessen lesen sie Daten aus und berechnen Wahrscheinlichkeiten. Darauf basierend treffen sie dann Entscheidungen. Das nennt man Machine learning (maschinelles Lernen).

Neuronale Netze

Technologie kann auch auf Basis von künstlichen neuronalen Netzen arbeiten – so eine Art Möchtegern-Nervensystem. Spezielle Algorithmen (also Richtlinien zur Lösung eines Problems) helfen der Maschine dabei, Muster in unstrukturierten Dingen wie Sprache, Bildern oder Musik zu erkennen und zu reproduzieren.

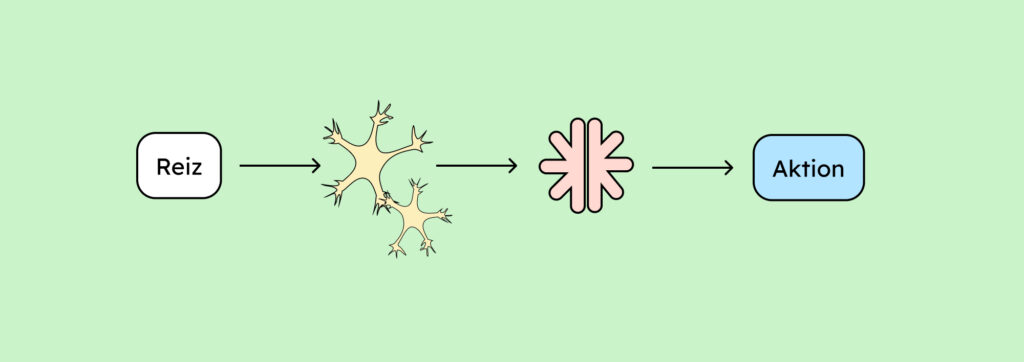

Was in neuronalen Netzen passiert, kannst du dir vereinfacht so vorstellen:

- Der Mensch nimmt einen Reiz über Sinnesorgane wahr (Ohren, Augen, Haut etc.).

- Die Sinnesorgane senden den Reiz als Signal an unser neuronales Netz.

- Von dort aus gelangt der Reiz ins Gehirn, wo er verarbeitet wird.

- Und Action! Das Gehirn veranlasst eine Handlung.

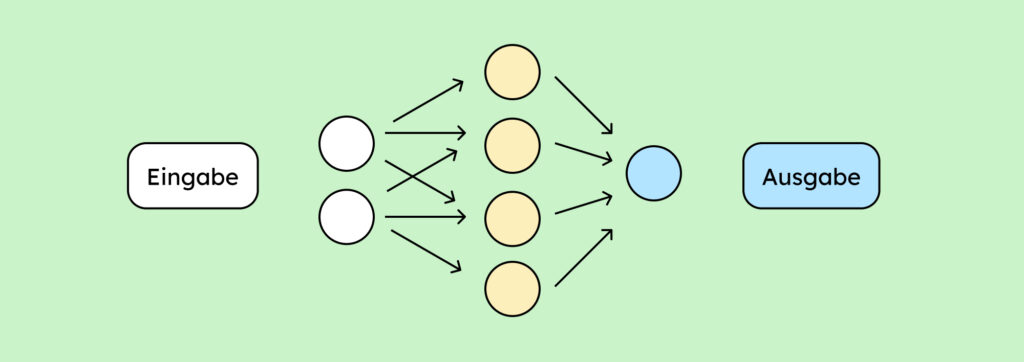

Der Unterschied zu einem künstlichen neuronalen Netz?

- Anstelle eines Reizes wird die Reaktionskette hier durch eine Eingabe ausgelöst (zum Beispiel dadurch, dass du eine Frage an ChatGPT stellst).

- Anstatt von menschlichen Neuronen geht die Eingabe an ein Netz aus Algorithmen und mathematischen Formeln.

- Diese erzeugen dann eine Ausgabe (zum Beispiel die schriftliche Antwort von ChatGPT auf deine Frage).

Anwendungsgebiete künstlicher Intelligenz

Das klingt jetzt alles sehr abstrakt und, als würde es nur in Tech-Laboren passieren. Aber mit Sicherheit bist du bewusst oder unbewusst auch schon mit künstlicher Intelligenz in Berührung gekommen.

Hast du dich schon mal gewundert, warum die Werbung auf Social Media genau weiß, mit welchem Pullover du schon lange liebäugelst? Oder wie Suchmaschinen es möglich machen, immer exakt die Antwort parat zu haben, die du suchst? Das liegt genau an dem oben genannten maschinellen Lernen.

Auch die von manchen so heiß geliebten persönlichen Assistenzen, mit den mittlerweile weltberühmten Vornamen, bedienen sich künstlicher Intelligenz. Dass du dich also auf der Familienfeier bei Onkel Harald köstlich über seinen Streit mit Alexa amüsieren kannst, hast du KI zu verdanken. Oder eher einer KI, die noch nicht vollends ausgereift ist, denn sonst müssten sie nicht streiten.

Darüber hinaus kann KI nützlich sein für:

- Kompakte Recherche

- Zusammenfassungen von Text- oder Bildinformationen

- Schnelle Entwürfe für die Visualisierung von Inhalten

- Automatisierte Abläufe

- Zum Brainstormen

Mittlerweile geht der Einsatzbereich natürlich weit über unseren Alltag hinaus. Durch Robotik können Maschinen beispielsweise schon physische Aufgaben erfüllen, die einen gewissen Grad an Feinmotorik erfordern. Mehr Anwendungsbeispiele für KI findest du hier auf der Seite des Europäischen Parlaments.

KI-Anwendungen für digitale Barrierefreiheit

Die Übergänge, wofür man Künstliche Intelligenz nutzen kann und wer davon profitiert, sind fließend. Sprachsteuerung zum Beispiel kann für Menschen mit und ohne Behinderung hilfreich sein. Ob ich keine Hände habe, oder meine Hände voller Donuts: in beiden Fällen ist es hilfreich, wenn ich meinen Anruf mit Sprachsteuerung annehmen kann.

Im Folgenden möchte ich ein paar Kontexte ansprechen, in denen KI gezielt für digitale Barrierefreiheit genutzt werden kann – ob erfolgreich oder nicht, das finden wir jetzt heraus!

Automatisierte Alternativ-Texte: Text aus Bild generieren

Ein beliebtes Einsatzgebiet ist das Bilder-Auslesen. Laut WCAG (Web Content Accessibility Guidelines) muss für Bilder auf Webseiten eine Text-Alternative hinterlegt werden. Entweder du beschreibst das Bild im Text oder du erklärst im Alternativ-Text, was auf den Bildern zu sehen ist. Da KI mittlerweile relativ gut Bilder ausliest, kann sie dabei helfen, diese mit Texten zu versehen (Voll verlassen kann man sich auf die KI in diesem Fall allerdings nicht, aber dazu später mehr).

Das Phänomen Bild-zu-Text gibt es mittlerweile tatsächlich auch andersherum. Das Photoshop-Tool Neural Filters kann Bilder durch schriftliche Anweisungen verändern. Statt das Wetter auf einem Foto aufwendig zu bearbeiten, kann ich also schriftlich anweisen, einen sonnigen Himmel einzufügen. Bildbeispiele und eine Erklärung, wie Neural Filters von Photoshop funktionieren, findest du hier auf der Adobe-Hilfe-Seite.

Automatisierte Untertitel: Geschriebenen Text aus Sprache generieren

Du hast sicher schon bemerkt, dass es mittlerweile oft automatische Untertitel zu Videos gibt. Sowohl soziale Medien wie Instagram als auch YouTube bieten diese Option. Auch hier ist diese KI am Werk und macht das, was du redest, zu Text! Das kann für Menschen, die schlecht hören, sehr hilfreich sein. Aber auch, wenn man keine Kopfhörer dabei hat und nicht das ganze Zugabteil beschallen will (Danke dafür!). Automatisierte Untertitel sind allerdings meist nicht barrierefrei, weil die Inhalte oft fehlerhaft sind. Sie helfen also nur bedingt.

Automatisierte Gebärdensprache: Avatare

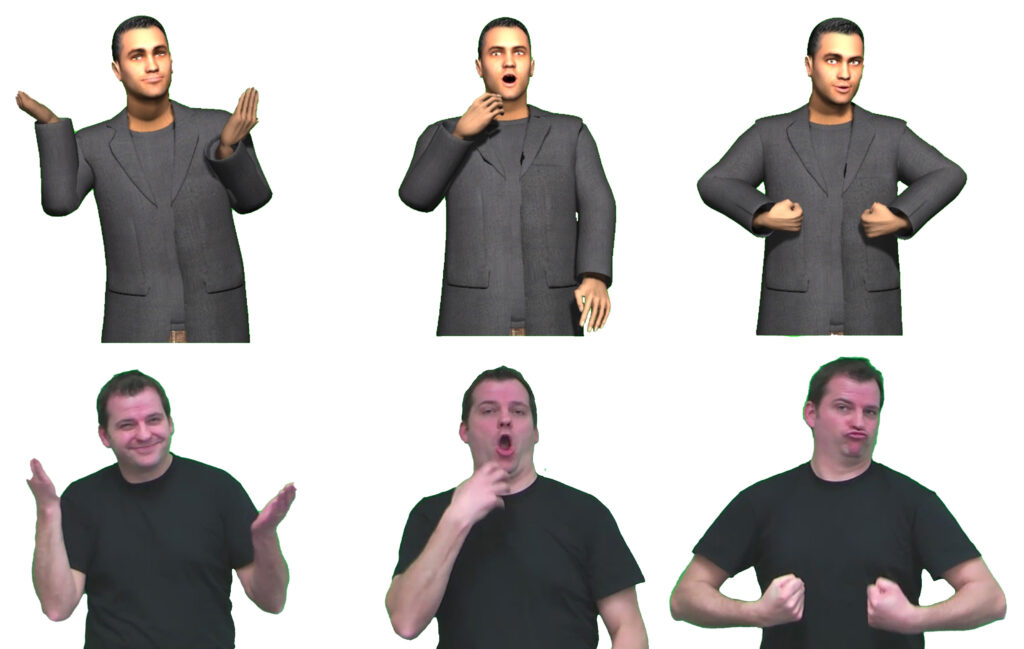

Für taube Menschen, deren Muttersprache die Gebärdensprache ist, sind Untertitel allerdings nicht ausreichend. Gebärdensprache hat eine eigene Grammatik und kann deswegen nicht durch Schriftsprache wiedergegeben werden. Doch auch hier gibt es schon Ansätze einer Lösung: Gebärdensprach-Avatare. Das sind animierte Personen, die Gebärdensprache dolmetschen sollen.

Genau wie maschinell generierte Alt-Texte und Untertitel, sind Avatare jedoch längst nicht ausgereift und bergen deshalb Risiken. Die Avatare sind nicht expressiv genug und werden schlecht bis gar nicht verstanden. Daher steht es bei Betroffenen stark in der Kritik. Außerdem fühlen sich Gebärden-Muttersprachler*innen nicht richtig repräsentiert.

Insgesamt also noch keine zufriedenstellende Lösung. Das gilt übrigens auch für synthetische Stimmen als Bild- oder Text-Alternative. Die Stimmen, die zur Verfügung stehen sind oft noch holprig und weit weg von menschlichen Stimmen. Betroffene, die auf Audio-Inhalte angewiesen sind, werden schnell überdrüssig und können nicht lange konzentriert folgen. Auf der anderen Seite gibt es in diesem Bereich auch schon wahnsinnige (zum Teil fast gruselige) Fortschritte. So können zum Teil sogar schon die Stimmen von spezifischen Personen imitiert werden. Es ist also vermutlich nur eine Frage der Zeit, bis Stimmen ausreichend künstlich generiert werden können.

Copyright DFKI

Auf dieser Grafik sieht man den Versuch einer Forschungsgruppe 2011 am DFKI (Deutsches Forschungszentrum für künstliche Intelligenz) einen animierten Gebärdensprachdolmetscher nach dem Beispiel eines gehörlosen Dozenten zu erstellen. Das Paper über die Erstellung eines Gebärdensprach-Avatars von der DFKI findest du hier.

Sprachübersetzung: Leichte und einfache Sprache

Einfache Sprache ist nichts Neues. Profis für UX-Design und Conversion-Rates versuchen seit Jahren, die Texte auf Webseiten so leicht verständlich wie möglich zu machen. Denn leicht verstanden werden, überzeugt potenzielle Kund*innen besser und deine Verkäufe steigen.

Weil jeder Mensch einfache Texte besser versteht, ist es auch für die digitale Barrierefreiheit immer ein Thema. Mehr über einfache Sprache.

Leichte Sprache geht einen Schritt weiter. Hierfür gibt es ein klares Regelwerk und sie muss immer von Expert*innen umgesetzt oder zumindest kontrolliert werden. Für die private Wirtschaft ist Leichte Sprache keine Pflicht, für öffentliche Stellen allerdings schon! Mehr zum Unterschied zwischen Leichter und einfacher Sprache findest du in diesem Artikel.

Auch für einfache und Leichte Sprache gibt es KI-Tools. Zur Seite von Capito – einem Tool für Leichte Sprache. Wichtig ist, dass diese Ergebnisse eben immer noch mal von Menschen und bei Leichter Sprache auch von Kontrollgruppen (Menschen mit kognitiven Beeinträchtigungen) geprüft werden müssen.

Gefahren bei der Anwendung von künstlicher Intelligenz

So beeindruckend und hilfreich KI auf den ersten Blick wirkt: sie ist weit davon entfernt perfekt zu funktionieren.

Fehlende Informationen bei Bildbeschreibungen

Natürlich wirkt es attraktiv, eine Datenbank mit hunderttausenden Bildern automatisch mit Alt-Texten zu versehen. Leider gibt es aber absolut keine Gewährleistung, dass die Texte alle wichtigen Informationen auf dem Bild wiedergeben.

Ein Beispiel:

Ich habe ChatGPT 4 ein Foto interpretieren lassen. Auf dem Bild sieht man eine Gruppe von Männern bei einer Bürgerrechts-Versammlung. ChatGPT hat das erkannt und beschreibt das Foto relativ genau:

„Eine Gruppe von Männern verschiedener Ethnien, gekleidet in Anzügen, steht entschlossen nebeneinander bei einer Versammlung. Einige tragen deutlich sichtbare runde Anstecker und ein Mann trägt einen gestreiften Strohhut. Im Hintergrund sind Schilder mit der Aufschrift “NOW!” zu sehen, was auf eine politische oder Bürgerrechtsveranstaltung hinweist. Die ernsten Gesichtsausdrücke der Männer spiegeln die Bedeutung des Moments wider.“

Ein wichtiger Fakt fehlt jedoch: Der Mann in der Mitte des Bildes ist Martin Luther King. Das kann mir ChatGPT allerdings nicht sagen. Denn es verstößt gegen die Richtlinien, Personen zu identifizieren. Das ist erst mal eine begrüßenswerte Richtlinie, die die Privatsphäre von Menschen schützen soll. Allerdings führt sie dazu, dass mir eine wichtige Information fehlt, die unter Umständen essenziell ist, um den weiteren Kontext zu verstehen.

In einer digital barrierefreien Umgebung sollte jeder Mensch Zugang zu allen Informationen haben. Das wäre hier nicht der Fall und somit braucht es einen Menschen, der den künstlich generierten Text kontrolliert und ergänzt.

Fehlerhafte Untertitel

Das Gleiche gilt selbstverständlich für Untertitel. Videos werden als Informationsmedium immer beliebter. Leider führt das oft zu massiven digitalen Hürden. Viele Menschen sind auf visuelle Ergänzung des Tons angewiesen. Super, dass es mittlerweile auf den meisten Plattformen automatisch generierte Untertitel gibt, oder?

Schwer zu sagen, denn oftmals sind die Untertitel fehlerhaft. Wörter, die ähnlich klingen, aber gegensätzliche Bedeutungen haben wie „kein“ und „ein“ werden verwechselt. Kleine, aber doch wichtige Wörter. Denn ob etwas „keine“ oder „eine“ Gefahr darstellt, sollte für alle klar hervorgehen.

Möchtest du also sichergehen, dass deine Untertitel barrierefrei sind, schreibe sie selbst mit Hilfe von Expert*innen. Alles rundum Untertitel kannst du auf der Seite des DCMP (Despribed and Captioned Media Program) finden (englisch).

Die Vorarbeit kannst du natürlich gerne ein Tool erledigen lassen. Wir machen das auch für unsere Videos mit dem Tool Descript. Zur Webseite von Descript, einem praktischen Werkzeug zur Erstellung von und Untertiteln.

Fake News!

In meinem Umfeld gibt es immer mehr Menschen (mich eingeschlossen), die ChatGPT gerne mal etwas fragen. Sie antwortet schnell und statt mich auf Suchmaschinen durch verschiedene Links zu klicken, bekomme ich eine Antwort, die auf meine Frage perfekt zugeschnitten ist. Ob die allerdings wahr oder erfunden ist, dafür gibt es keine Garantie.

ChatGPT schreibt oft lange Texte, ist eloquent und freundlich und wirkt dadurch sehr überzeugend. Sie holt sich ihr Wissen allerdings auch nur – wie wir bereits gelernt haben – von menschengemachten Quellen. Hat die breite Masse im Internet eine Fakten-ablehnende Meinung, kann es dazu führen, dass GPT diese für die Wahrheit hält. Und wir wissen alle: Die breite Masse hat längst nicht immer recht.

Ein Beispiel:

In einem Artikel der Zeit wird von einem solchen Fall berichtet: Das Unternehmen „News Guard“, welches sich mit der Vertrauenswürdigkeit von KI beschäftigt, hat ChatGPT 4 auf die Probe gestellt. 100 von 100 suggestiven Fragen wurden falsch oder irreführend beantwortet. Den Artikel der Zeit über Falschinformationen von ChatGPT findest du hier.

Natürlich sind das oft Grauzonen. Was ist suggestiv? Was ist eine Falschinformation? Je nach Bubble, in der wir leben, streiten Menschen auch darum, was Fakten sind. Selbst die Wissenschaft als Instanz scheint oft leider keine Objektivität zu vermitteln. Das heißt natürlich nicht, dass ChatGPT ausschließlich Fake News verbreitet. Wichtig ist (und das gilt selbstredend für alles im Internet): Check your facts! Nur weil es eine KI gesagt hat, ist es nicht zwingend wahr. Auch, wenn sie es sehr gut verkauft.

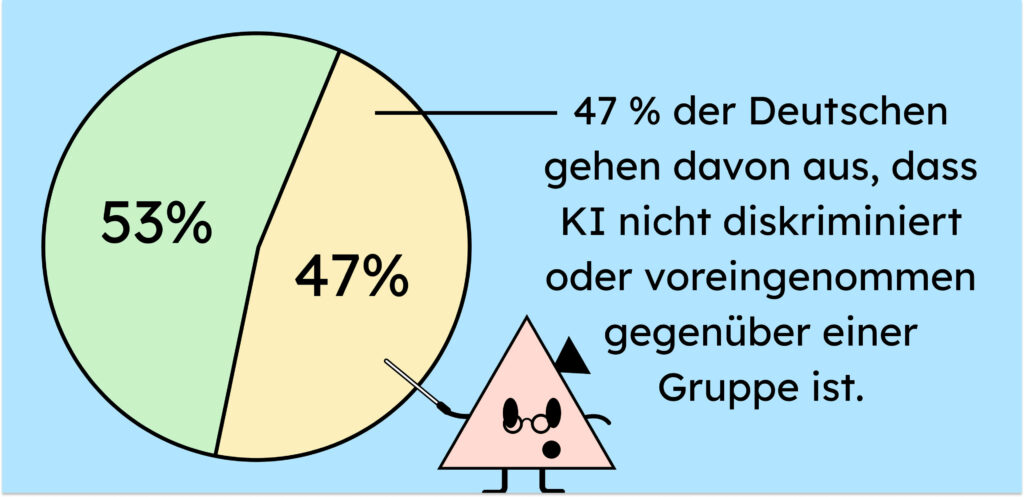

Verstecke Diskriminierung

47 Prozent der Menschen in Deutschland vertraut laut dieser Statistik darauf, dass KI nicht diskriminierend ist. Das ist ziemlich alarmierend, denn wir haben nun hoffentlich verstanden: Die KI weiß vielleicht mehr als der einzelne Mensch, nicht aber mehr als die Menschheit. Das, was sie weiß, bringen wir ihr bei. Leider können wir dabei auch nicht so ganz aus unserer Haut. Sie lernt also auch unsere Schwächen kennen. Und wie bei der Erziehung eines Kindes, saugt sie auch Vorurteile, ableistisches Verhalten und generell Diskriminierung marginalisierter Gruppen auf. Das passiert also selbst, wenn diese Dinge nicht explizit gelehrt werden.

Ein Beispiel:

In einem sehr guten Vortrag von Casey Kreer (Hier gelangst du zu Caseys Linkedin Profil) für die Tollwerk GmbH, erzählt Casey von einem Bias (Voreingenommenheit), auf den sie bei ihrem KI-Tool stößt:

Sie bittet ChatGPT 4 Bilder einer blinden Person zu generieren. Die Anweisung hält sie bewusst vage, um Raum für Interpretation zu lassen.

Die sechs generierten Bilder ähneln sich alle stark. Auf allen sechs Bildern ist ein weißer Mann mittleren Alters in einer städtischen Umgebung zu sehen, der einen Gehstock und eine Sonnenbrille oder eine Augenbinde trägt. Das zeigt deutlich, dass ChatGPT geprägt ist wie ein Mensch. Die Darstellung ist alles andere als divers. Sie ist ableistisch und lässt keinen Raum für Diversität im Hinblick auf Gender, Ethnie, Alter oder Körpertyp zu. Den Vortrag von Casey Kreer fürs Tollwerk zum Thema Barrierefreiheit und KI findet ihr hier!

Falls du dich jetzt fragst, ob das wirklich so schlimm ist – schließlich wurde ja nichts Falsches dargestellt – bist du unterbewusst Teil des Problems. Denn so vertieft KI Klischees, Vorurteile und verstärkt Diskriminierung. „Moment! Ich will nicht Teil eines Problems sein, ich will Teil der Lösung sein!“. Wenn das dein nächster Gedanke war, super! Sprich ChatGPT das nächste Mal darauf an, wenn du das Gefühl hast, dass sie diskriminiert. KI ist sehr lernbereit und wird dir anbieten, ihre Antwort anzupassen und hoffentlich daraus lernen.

Also was jetzt: Nützliches Werkzeug oder Finger weg von KI-Tools?

Ich könnte die Liste der Gefahren bei der Nutzung von KI noch um einiges ergänzen. Die Liste der Vorteile aber auch!

Was du auf jeden Fall mitnehmen kannst aus diesem Artikel:

- KI ist gekommen, um zu bleiben. Sie wird immer mehr zum festen Bestandteil unserer Technologie und damit unseres Lebens.

- Sie wird nie „fertig“ sein, sondern ständig lernen und optimiert werden.

- KI-Tools sind meist sehr nützliche Anwendungen mit großem Potenzial.

- Sie bergen bei falscher Nutzung Risiken und Gefahren.

- KI sollte daher immer von Menschen betreut und kontrolliert werden.

- Es ist wichtig, was Du der KI „fütterst“. Mache dir bewusst, dass deine Eingabe die Ausgabe steuert (Ja, jetzt kommt die Wahrheit ans Licht: Dumme Fragen gibt es eben doch!).

- KI ist nicht allwissend. Sie vervielfältigt auch Informationen, die unter Umständen falsch sind.

- KI hat Grenzen und Einschränkungen (z. B. wenn etwas gegen ihre Richtlinien verstößt).

Bei der Recherche für diesen Artikel bin ich auf die verschiedensten Meinungen gestoßen. KI ist auch ein emotionales Thema. Viele Menschen fühlen sich bedroht davon oder haben Angst, dass ihre Arbeit überflüssig wird. Andere feiern, wie viel KI schon leisten kann.

KI im Alltag

Meiner Meinung nach sollten wir alle mal einen Blick auf KI werfen. Sie kann eine wunderbare Ergänzung sein zu den Tools, die wir ohnehin schon nutzen. Es ist immer wichtig, dem Fortschritt gegenüber offenzubleiben. So haben wir die Möglichkeit, ihn zu verstehen und produktiv zu kritisieren.

Wenn ich mich versperre, weiß ich nicht, worum es geht. Mir fehlt das Wissen, um Neues sachlich einzuschätzen. Und ich beraube mich der Vorteile, die der Fortschritt unter anderem bringt.

Daher ist es sinnvoll, sich mit KI zu beschäftigen. Ob man sie nutzen möchte, ist natürlich jedem selbst überlassen. Wichtig ist in jedem Fall, offen UND kritisch zu bleiben.

KI in der digitalen Barrierefreiheit im öffentlichen Bereich

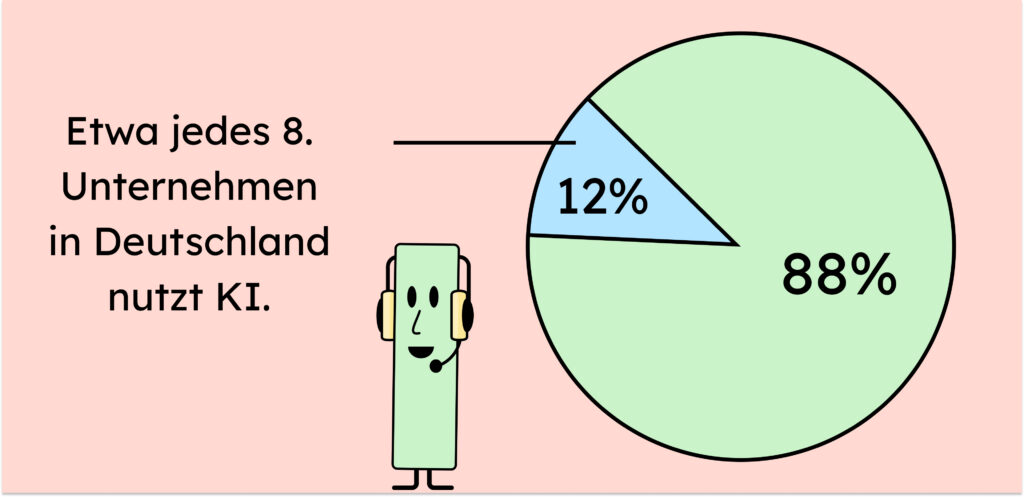

Wie du hier beim Bundesamt für Statistik nachlesen kannst, nutzen 12% der deutschen Unternehmen (mit mindestens 10 Mitarbeiter*innen) KI. Setzt du KI im öffentlichen Bereich ein, gilt besondere Vorsicht. Mehr Publikum, mehr Folgen, mehr Verantwortung! Und verantwortungsvoller Umgang bei der Verbreitung von Informationen ist unabdingbar. Diese Verantwortung trägst du auch, wenn die Informationen von einer vermeintlich intelligenten Quelle stammen.

Natürlich können KI-Anwendungen helfen, barrierefreier zu werden. Die letzte Prüf-Instanz vor Veröffentlichung sollte allerdings immer der Mensch sein. Hier findest du ein YouTube-Video mit einer sehr interessanten Diskussion einiger Expertinnen und Experten zum Thema KI in der Barrierefreiheit. Aus ihr geht deutlich hervor, dass Betroffene, wie Casey Keer, lieber keinen Alt-Text, als einen schlechten, irreführenden Alt-Text vorfinden. Nur weil uns KI quantitativ viel Arbeit abnehmen kann, heißt das eben nicht, dass sie Qualität liefert.

Ein guter Ansatz, den ich ebenfalls aus dieser Diskussion von Heinz Schilling mitnehmen konnte: Statt zu versuchen, die Unmengen an Daten barrierefrei zu machen und dabei zu scheitern, sollten wir die Mengen reduzieren. Qualität statt Quantität. Inhalte pflegen und aussortieren. Das spart Zeit und Geld. Zeit, die wir dann nutzen können, um KI-generierte Inhalte zu prüfen und anzupassen und Barrierefreiheit direkt zu implementieren.

Was kann ich also tun, um KI sinnvoll für Barrierefreiheit zu nutzen?

- Nutze KI für Struktur und nicht für Inhalt. Du kannst dir Quellen zusammenfassen und gliedern lassen. So sparst du Zeit, ohne Risiken beim Inhalt einzugehen.

- Nutze KI-Tools für die Vorarbeit (Übersetzung in einfachere Sprache) und überlasse den Feinschliff einem Menschen bzw. Expert*innen (vs. Übersetzung in Leichte Sprache).

- Überprüfe alle Inhalte, die du von KI generieren lässt. KI ist nicht fehlerfrei und somit nicht vertrauenswürdig.

- Erkundige dich bei Betroffenen. Sie können am besten rückmelden, ob deine KI-Maßnahmen für sie funktionieren.

- Lege Wert auf Qualität statt Quantität. 1000 fehlerhafte Alt-Texte sind schlechter als keine Alt-Texte

- Überlege, ob es Sinn ergibt, deinen KI-generierten Inhalt als solche zu markieren. Wenn Betroffene wissen, dass Inhalte künstlich generiert sind, können sie selbst entscheiden, ob sie ihnen vertrauen.

KI wird in der Barrierefreiheit oft von Leuten verkauft, die Barrierefreiheit selbst nicht benötigen. Sie können oft nicht beurteilen, ob die Anwendungen wirklich sinnvoll sind. Es ist unabdingbar, Menschen mit Behinderung in den Prozess der Barrierefreiheit einzubeziehen. Wenn diese die Tools als unzureichend bewerten, dann sind sie unzureichend. Außerdem ist es wichtig, den Menschen freizustellen, ob sie KI vertrauen wollen. Dazu braucht es transparente Kommunikation, wo immer sie eingesetzt wird.

Der goldene Mittelweg

Es ist wohl völlig fernab der Realität zu denken, dass wir die Menge an Inhalten und Informationen, die bereits bestehen, ohne KI barrierefrei bekommen. Selbst mit KI sieht es momentan schwierig aus. Wir erschaffen einfach schon sehr lange eine digitale Welt voller Hürden.

Am Ende wird man also erst einmal auf Kompromisse zurückgreifen müssen, wie kontrollierter Einsatz von KI oder gekennzeichnete Ergebnisse, die nur als Zwischenlösung bestehen. Die ultimative Lösung im Hinblick auf Barrierefreiheit ist KI im Moment auf jeden Fall nicht, ob sie es wird, darüber scheiden sich die Geister.

Zukünftig wäre es begrüßenswert, wenn wir unsere Workflows direkt so einrichten, dass wir KI bedenkenlos einbeziehen können. KI wird immer intelligenter und besser. Es liegt also an uns, sie gewinnbringend zu nutzen, die Risiken im Hinterkopf zu behalten und mit dem Fortschritt zu wachsen.